人文学向けデジタルテキスト作成の国際デファクト標準、TEIガイドラインでルビが導入されました

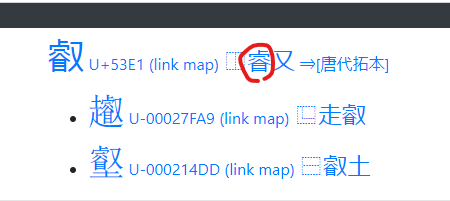

2月25日付けで、TEI協会が策定・公開している人文学資料のデジタル構造化の国際デファクト標準である TEI ガイドラインの version 4.2.0がリリースされ、 日本語のルビが導入されました(リリースノート)。

これにより、ルビが付された膨大な日本語テキスト資料をTEIガイドラインに準拠して構造化することが、これまでとは比べものにならないくらい簡便になりました。このことは、 国際的な人文学向けデジタルテキスト構築の流れの中に、ルビ付の日本語テキストデータをそのまま組み込むことができるようになったということでもあります。

注:ルビ以外の本文外要素、いわゆる訓点や脚注・欄外注などの色々な要素は基本的にTEIガイドラインでは昔から対応可能でした。(詳しくはこちら)さらに言えば、ルビも工夫すれば記述できていましたが、それを単純に「ルビ」という構造として記述できるようになったのが今回の「ルビの導入」です。

TEIガイドラインが欧米の人文学研究者コミュニティによりニューヨーク・ポキプシーで始まって以来、34年目にしてようやくの画期的な出来事です。TEIガイドラインが始まったころは多言語テキストを作成するだけでも大変な事でしたが、多言語(文字)を一つのコード表で扱うUnicodeの普及やコンピュータ処理、ネットワーク転送の高速化といった技術の進歩によって、技術的には可能になってきたものでした。しかしながら、人文学一般におけるテキスト資料の構造としての必要性という観点からは、特定の言語文化圏に根ざした構造を認めることはハードルが高く、そういった観点からルビの導入にはなかなか難しいものがありました。

TEIを策定するコミュニティは人文学向けデジタル資料を適切に構造化したいという組織や人が集まっています。そして、そこで選挙で選ばれたメンバーから成る技術委員会が中心になって 策定しているのがTEIガイドラインです。したがって、それに積極的に関わりたいという意思を持つ人・組織が集まった任意団体として運営されてきており、組織が拡大するに つれて、技術が発展するにつれて、様々な分野への細やかな対応が可能になってきています。たとえば、2011年12月には手書き資料の翻刻をより厳密・忠実に行うこともできるようにするための 大規模なアップデートが行われたり、2015年4月には書簡を機械可読処理しやすくするためのアップデートが行われたり、2020年8月にはLinked Data等の本文に直接書き込まれない データを書きこむためのエレメントを導入したりしています。そのようななかで、今回、ルビの導入がTEIガイドラインのコア要素に組み込まれる形で行われました。

今回のルビの導入は、日本のテキスト資料を扱う人々にとって有益というだけでなく、 漢字文化圏という巨大なテキスト群を抱える地域の周縁においてそれを読解するために生み出されたローカルルールが、 人文学の研究手法に関する国際的なコミュニティにおいて対処すべき一つの構造として受容されたということでもあります。換言すれば、欧米外の地域における多様なテキスト文化のローカルな慣習にも同等の価値を置くという、 コミュニティからの正式な表明でもあります。 このことについて、TEI技術委員会の英断と、そこに至る状況を醸成してきたコミュニティに深く感謝しております。 一方、このような状況を作り出すことに日本語文化圏が貢献できたということは、 テキストを読むことに親しんできた日本語圏の先人達の膨大な積み重ねが結実した結果でもあり、その意味では感慨深いものがあります。

というわけで、ここまでの流れを少し個人的な視点で以下にまとめておきたいと思います。

ここまでの流れをおおまかに

ここに至るまでには、TEIコミュニティへの東アジア研究のコンテクストからの働きかけがありました。流れとしては1990年代前半に一度盛り上がった時期があった ようですが、私は直接には触れることがなく、流れとしてもいったん切れてしまったような感じがあります。その後、2006年に、クリスティアン・ヴィッテルン先生が中心となって 京都大学人文科学研究所の21COEプロジェクトで開催されたTEI Day in Kyoto 2006が、現在の流れを作るきっかけになったように思います。

その後、TEIの国際化という観点では、TEIガイドラインのタグ・エレメントの説明部分を多言語化するというプロジェクトがあったようで、日本からは鶴見大学の大矢一志先生が頑張ってくださり、タグ・エレメントの説明を日本語で読むことができるようになりました。

さらにしばらく時間が空きますが、この間、個人的には、TEIのスペシャリストが日本に来てくださったのでTEIのセミナーをやっていただいたり、日本デジタル・ヒューマニティーズ学会が設立されたのでそこでまたTEIのセミナーを企画してみたり、ということを細々とやっておりました。そうこうしながら色々課題を整理してきて、やはりルビだけはなんとかしなければ、ということと、一方で、日本語資料の場合にはどのように使うべきかという日本語で書かれたガイドラインが必要であることを痛感し、しかし、一人で頑張ってもどうにもならないので、どうしたものかとあれこれ案を練っておりました。

結局のところ、欧米資料が主眼になっているTEI協会にも歩み寄ってもらわないと問題は解決しないだろうと思い至り、 主に科研費事業「仏教学新知識基盤の構築―次世代人文学の先進的モデルの提示(代表:下田正弘東京大学教授)」の下、 国際コミュニティでのローカルルールの重要性についての 議論を始めました。ちょうど、デジタル・ヒューマニティーズの国際コミュニティでもグローバル化が大きな課題になっていましたので(今もそうですが)、 その流れの一環という位置づけも意識しながら、ポーランドのクラクフで開催されたDH2016で以下の発表を行い、それを以て、Charles Muller氏とともにTEI協会に東アジア/日本語分科会の正式な設立を申し入れました。

Nagasaki, K., Tomabechi, T., Muller, C., Shimoda, M. (2016). Digital Humanities in Cultural Areas Using Texts That Lack Word Spacing. In Digital Humanities 2016: Conference Abstracts. Jagiellonian University & Pedagogical University, Kraków, pp. 300-303.

そこで、2016年には東アジア/日本語分科会の設立が認められ、さらにそのなかに運営員会を設立、初期メンバーとして岡田一祐氏、中村覚氏、永崎、ということで、日本語ガイドラインやルビ導入のための提案書の作成に着手しました。その後は、勉強会や翻訳会などをこまめに開催しながら、作成した情報やデータをGitHubに集積していき、主に中村覚氏により開発された様々な視覚化ツールも提供されるようになり、日本国内でTEIに準拠したデータを作成する研究プロジェクトも徐々に増えていきました。対応するプロジェクトが増えると用例が増えて、使い方もわかりやすくなっていくという循環がようやくできてきたのもこの頃です。

TEI協会側でも国際化に関する動きが進み、2018年に初めての欧米域外での会員総会としてTEI2018@Tokyoを日本デジタル・ヒューマニティーズ学会(JADH)との共催で開催し、2020年2月にはInternationalization (I18n) Working Group が設立され、多言語利用のための環境整備が始まったりもしました。

さらに、同じ時期には、延喜式のTEIエンコーディングへの取り組みを通じて小風尚樹氏が単位の記述に関する問題提起を行い、一連の議論を経て2019年8月に<unitDecl>関連のタグが ver. 3.6.0に導入されました。

そのようななかで、ルビ導入の提案書は、平仮名の研究者である岡田一祐氏を中心として運営委員会で作成されました。これもオーストリア・グラーツでのTEI協会会員総会で以下の研究発表をするなど、相応の時間を要し、深夜に2度の対面オンライン技術委員会に運営委員皆で参加し、Githubでも色々な議論がありましたが、最終的には、TEI技術委員会の皆様のご理解と、特に日本語に理解のあるヴィクトリア大学のMartin Holmes氏の献身的な協力もあり、なんとか導入に至った、という次第です。version 4.2.0のコードネームが「ruby」となっているところからも、技術委員会の方々の本気度が感じられるところでしたが、最終的に、<ruby>はTEIガイドラインのコア要素の中に組み込まれることになりました。今後のガイドラインの発展のことを考えるなら、かなり大きな決断だっただろうと想定されます。

Kazuhiro Okada, Satoru Nakamura, Kiyonori Nagasaki, An Encoding Strategic Proposal of “Ruby” Texts: Examples from Japanese Texts

他にも色々な状況があり、全体をきちんと記述できているわけではないと思いますが、筆者からみえている、本件に関わる状況は大体このような感じでした。日本文化をデジタル世界に通用するものにしていくために やらねばならないことはまだまだ山積しておりますので、みなさまのお力をぜひ発揮していただきたく、今後ともよろしくお願いいたします。